Cambridge Dictionary ha selezionato ‘hallucinate’ come parola dell’anno per il 2023: se fino a qualche tempo fa il termine poteva essere associato alle percezioni alterate dovute allo stato di salute o al consumo di droghe, il suo significato è stato ora aggiornato per identificare le bufale che ogni tanto gli strumenti di intelligenza artificiale come ChatGPT, Bard e Grok tendono a rifilarci.

Così l’AI ‘allucina’ l’utente offrendo informazioni sbagliate con sicumera e spesso, invece che nonsense, in un modo che appaiano plausibili.

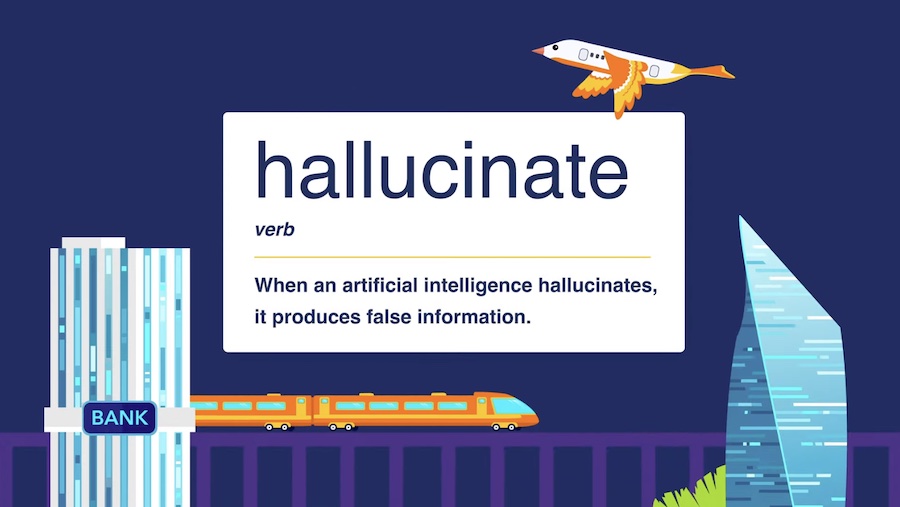

Questa la definizione aggiornata di ‘hallucinate’:

“Quando un’intelligenza artificiale (un sistema informatico che ha alcune delle qualità del cervello umano, come la capacità di produrre linguaggio in modo che sembri umano) allucina, produce informazioni false.”

Ci sono stati casi di cronaca in cui l’AI ha ‘allucinato’ utenti poco accorti: ad esempio come quando uno studio legale statunitense ha usato ChatGpt per una ricerca legale spingendolo a citare un caso fittizio in tribunale, oppure Google stesso che nello spot promozionale di Bard ha citato dati sbagliati riguardo il telescopio spaziale James Webb.

«Il fatto che le intelligenze artificiali possano ‘allucinare’ ci ricorda che gli esseri umani devono applicare il pensiero critico nell’uso di questi strumenti – ha commentato Wendalyn Nichols, Publishing Manager di Cambridge Dictionary. Le intelligenze artificiali sono fantastiche nel processare enormi quantità di dati per estrarre informazioni specifiche e consolidarle. Ma più chiediamo loro di essere originali, più è probabile che si smarriscano. Gli LLM possono essere affidabili se lo sono i dati con cui vengono addestrati. L’esperienza umana è dunque più importante e necessaria che mai nel creare informazioni autorevoli e aggiornate su cui gli LLM possono essere addestrati»

Henry Shevlin, AI ethicist dell’Università di Cambridge, ha aggiunto una riflessione sulla tendenza da parte degli umani di antropomorfizzare l’intelligenza artificiale, di cui utilizzo del termine ‘allucinare’ per riferirsi agli errori dei sistemi come ChatGPT è una manifestazione: «Informazioni inesatte o fuorvianti sono sempre state con noi, che si tratti di voci, propaganda o ‘fake news’. Mentre queste sono normalmente considerate prodotti umani, ‘allucinare’ è un verbo evocativo che implica un agente che vive uno stacco dalla realtà. Questa scelta linguistica riflette uno spostamento sottile ma profondo nella percezione: l’IA, non l’utente, è quella che ‘allucina’. Sebbene questo non suggerisca una diffusa credenza che l’IA sia senziente, sottolinea la nostra prontezza nel attribuire attributi simili a quelli umani all’IA. Col passare degli anni, mi aspetto che il nostro vocabolario psicologico si estenderà ulteriormente per comprendere le strane abilità delle nuove intelligenze che stiamo creando».