Il codice stabilisce i principi etici e le buone pratiche per l’utilizzo responsabile dell’IA nelle attività editoriali e professionali del gruppo

Il Gruppo 24 Ore adotta un codice di autodisciplina per l’applicazione etica dell’intelligenza artificiale (IA) all’interno delle sue attività editoriali e professionali.

Il codice, elaborato con il contributo di esperti interni ed esterni e condiviso con le redazioni del Gruppo, si ispira ai principi e alle raccomandazioni delle principali organizzazioni internazionali e nazionali, come l’AI Act approvato dall’Unione Europea e la relazione della Commissione IA per l’Informazione del Governo italiano, e si propone di garantire che l’utilizzo dell’IA sia in linea con i valori di onestà, correttezza e trasparenza che hanno sempre guidato il Gruppo nei suoi quasi 160 anni di storia.

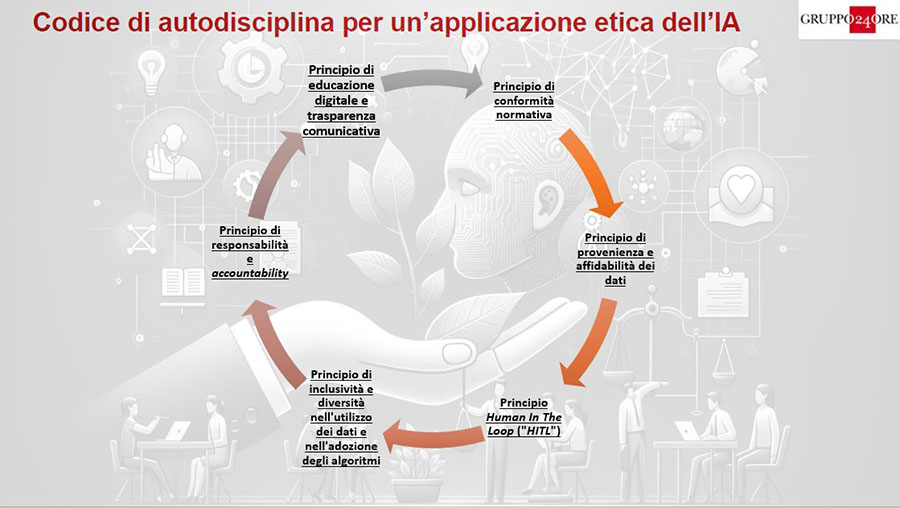

Il codice si articola in sei principi fondamentali:

Conformità normativa: il gruppo si impegna a verificare che qualunque scelta relativa all’applicazione di modelli di IA nel Gruppo si sviluppi attraverso un utilizzo corretto e consapevole degli strumenti dell’IA, in modo da massimizzarne i vantaggi evitando comportamenti rischiosi, violazioni delle politiche aziendali o della normativa. Nell’utilizzo dell’IA vanno sempre tutelati il rispetto della privacy, la gestione efficace dei dati personali, la protezione del diritto d’autore e della proprietà intellettuale, del Gruppo o di terzi.

Provenienza e affidabilità dei dati: il gruppo si impegna a garantire che i dati utilizzati per alimentare i sistemi di IA siano pertinenti, accurati, completi, aggiornati, sempre sotto la responsabilità del Gruppo. Tutti i dati dovranno provenire da fonti attendibili e verificate, valorizzando la trasparenza in relazione all’origine, e dovranno essere revisionati periodicamente per garantirne l’attualità, integrità e rilevanza.

Human in the loop: il gruppo assicura la centralità dell’imprescindibile ruolo umano e professionale nel processo di sviluppo e adozione dell’IA e, pertanto, garantisce che le decisioni e le azioni basate sull’IA siano sempre sottoposte al controllo e alla supervisione umana. In questo modo i professionisti e gli operatori che utilizzano lo strumento potranno sempre mantenere autonomia valutativa e decisionale. In ambito giornalistico, l’IA sarà utilizzata esclusivamente come supporto all’attività dei giornalisti e non in sua sostituzione, garantendo qualità, imparzialità e pluralismo informativo.

Inclusività e diversità: il gruppo promuove l’uso dell’IA per favorire l’inclusività e la diversità ed evitare ogni genere di discriminazione attraverso revisioni costanti di algoritmi e dataset che devono essere rappresentativi della varietà socioculturale per prevenire stereotipi e informazioni scorrette e promuovere soluzioni che siano eticamente fondate e socialmente responsabili.

Responsabilità e accountability: il gruppo si impegna a far sì che ogni utente – a prescindere dal proprio ruolo nella struttura aziendale – assuma la propria responsabilità nell’utilizzo dell’IA, in quanto le responsabilità individuali, le competenze e la “presa in carico” sono da considerarsi essenziali per l’integrazione e l’utilizzo dell’IA nei processi produttivi e decisionali. Considerando che il risultato generato da un sistema di IA è potenzialmente imperfetto, prima di utilizzarlo sarà necessario verificare che tale risultato sia corretto e accurato.

Educazione digitale e trasparenza comunicativa: il gruppo si impegna a diffondere la cultura e la conoscenza dell’IA tra i propri dipendenti e collaboratori attraverso percorsi formativi, equamente accessibili a tutti i livelli aziendali, con l’obiettivo di abilitare sia le competenze tecniche delle persone sia la capacità di comprensione delle implicazioni etiche e sociali dell’uso dell’IA. Parallelamente, promuove una comunicazione chiara e trasparente sull’impiego dell’IA, che consenta a qualunque professionista ed operatore di poterla utilizzare nel rispetto della legge e dei diritti di terzi, e garantisce trasparenza anche nell’identificare i prodotti elaborati attraverso l’utilizzo di sistemi di IA.

COME IL GRUPPO 24 ORE STA SPERIMENTANDO L’IA

Il Gruppo 24 Ore sta da tempo sperimentando diverse applicazioni di IA generativa in vari ambiti a partire da quello giornalistico, con strumenti che supportano i compiti di ricerca, analisi, sintesi di notizie e correlazione di contenuti affini per rendere ancora più semplice la lettura da parte degli utenti dei contenuti di loro interesse – sempre sotto il controllo e la supervisione umana e sempre e solo nell’ambito di dati interni – fino all’implementazione di piattaforme digitali con sistemi di recommendation che permettono di personalizzare l’esperienza degli utenti, offrendo contenuti e servizi in linea con i loro interessi e le loro esigenze.

Sul fronte dei prodotti, il Gruppo 24 Ore ha già iniziato ad integrare l’IA generativa nelle sue banche dati professionali e, in particolare, nel servizio di punta L’Esperto Risponde, che fornisce risposte qualificate e aggiornate a quesiti di natura fiscale, legale, amministrativa e tecnica, aumentandone in maniera esponenziale le sue performance.

La nuova release dell’Esperto Risponde powered by AI, che sarà rilasciata in autunno, sarà dotata di un assistente virtuale basato sull’IA in grado di comprendere il linguaggio naturale e fornire – sempre sotto la guida dei propri esperti – risposte tempestive e precise, grazie all’utilizzo esclusivo della propria base dati, con nuovi livelli di servizio e funzionalità.